芝能智芯出品

戴尔在 2025 台北国际电脑展期间发布了全球首款搭载企业级独立 NPU 的移动工作站——Pro Max Plus,打破了传统笔记本以 GPU 为核心的 AI 运算架构,还首次将高通 Cloud AI 100 加速卡引入移动终端,在本地大模型推理能力、功耗控制、内存容量等多个关键维度上实现飞跃。

本地的NPU能做些什么?AI PC最终能发展成什么样?我们一直在关注。

Part 1

架构壁垒:从 GPU 到 NPU

过去十年,移动工作站在追求 AI 性能时始终绕不开 GPU,尤其是 NVIDIA 的专业显卡,几乎成了 AI 开发者的“标配”。然而,随着大语言模型(LLM)参数量级的暴涨,传统 GPU 的内存瓶颈与能效比问题日益突出。

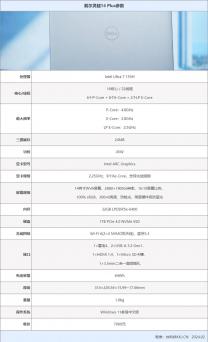

戴尔 Pro Max Plus 的横空出世,搭载两颗高通 Cloud AI 100 推理加速卡,共计 32 个 AI 核心,并配备高达 64GB LPDDR4x 专用内存,远超同级别 NVIDIA RTX PRO Blackwell 系列 GPU 所能提供的本地内存容量(通常为 24GB)。

更关键的是,戴尔宣称这套系统可以在完全离线的状态下,运行参数规模高达 1090 亿的 Llama 4 Scout 模型,覆盖了从 AI 聊天机器人、智能体 Agent,到大规模多轮对话系统的完整推理需求。

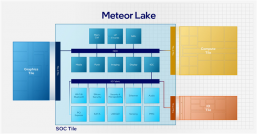

从硬件架构看,Qualcomm AI 100 并非单纯的神经网络处理器(NPU)延伸,它承袭了云端 AI 加速器的设计理念,将高带宽 SRAM(288MB)与片上 AI 核心紧密集成,极大减少了推理延迟。

同时,板载 LPDDR4x 内存带宽高达 274GB/s,与系统总线协同设计,使其在高频数据吞吐场景下依旧保持稳定。

这套方案的意义不仅在于单机性能突破,颠覆了开发者对“GPU 必不可少”的惯性认知。

以往,训练与部署模型往往是在数据中心和本地 GPU 之间反复迁移。而戴尔这次带来的,企业级 AI 工作负载,可以被压缩、优化、并直接部署于笔记本上独立运行,从而实现边缘侧 AI 的真正落地。

Part 2

重塑开发流程:

本地大模型推理

与 AI Studio 的结合

从应用视角来看,戴尔 Pro Max Plus 更像是一个“便携式 AI 数据中心”,瞄准了 AI 模型开发者、企业智能体工程师、游戏引擎生成算法团队等专业用户。借助 Pro AI Studio,这款移动工作站承担算力角色,更是一个完整的 AI 开发环境。

Pro AI Studio 是戴尔此次同步推出的软件平台,提供模型管理、推理调度、一键部署等功能,支持用户快速调用包括 Llama 系列、Gemma、Phi、Claude 等主流开源和私有大模型。

在展台现场,官方演示了基于该平台的游戏世界构建工具,只需几句 prompt,AI 即可根据语言描述完成实时内容生成,场景复杂度和交互逻辑明显优于传统 AIGC 工具链。

本地部署不再需要频繁上传用户数据至云端。对于金融、医疗、政企客户而言,这种“数据不出本地”的运行方式,极大降低了数据泄露与监管合规的风险。

戴尔还指出,随着模型量化与剪枝技术的成熟,未来即便是千亿级模型,也能在更紧凑的移动设备中实现无缝运行,从而拓展至更多嵌入式和边缘场景。

当前版本舍弃了 NVIDIA GPU 所擅长的图形渲染与多媒体管线,例如实时光线追踪、视频转码等仍需依赖专门硬件或云端协同。

但对于专注 AI 推理和模型原型设计的用户而言,这种取舍是合理的——他们所需要的是高吞吐、低功耗、可扩展的本地 AI 执行平台,而非通用图形处理器。

戴尔此次的设计依旧处于“原型验证”阶段,Pro Max Plus 的大规模量产尚未公布确切时间。高通 AI 100 的模块尺寸和功耗表现也还在优化中。

尽管如此,这款设备所传递的理念已然清晰:AI 开发未来并非只能依赖数据中心,强大的本地 AI 引擎同样可以嵌入进轻薄便携的终端中,催生“随时可部署、随地可推理”的智能生产力形态。

小结

AI 工作站开始存在介于传统 GPU 工作站与轻量级内置 NPU 笔记本之间,以企业级独立 NPU 为核心,实现本地大模型推理的能力,对于那些更关注推理端性能、移动性和隐私合规的企业客户而言,Pro Max Plus 所开辟的路线,无疑提供了一个更具可控性与成本优势的选项。

原文标题 : 戴尔 Pro Max Plus:独立 NPU 登陆移动端