上次我们给大家带来了关于CNN与图像分割主题的论文,本次的主题是目标检测,包含2D、3D的目标检测,旋转目标检测,视频目标检测,同样每篇论文都附带论文代码,大家在阅读论文的同时也可亲自动手实践,快来看看吧!

目标检测

目标检测是与计算机视觉与图像处理的计算机技术,处理的是在数字图像和视频中检测出的特定类别的语义对象(如人类、建筑物或汽车)的实例。目标检测的研究领域包括人脸检测和行人检测。目标检测在计算机视觉的许多领域都有应用,包括图像检索和视频监控 。

2D目标检测

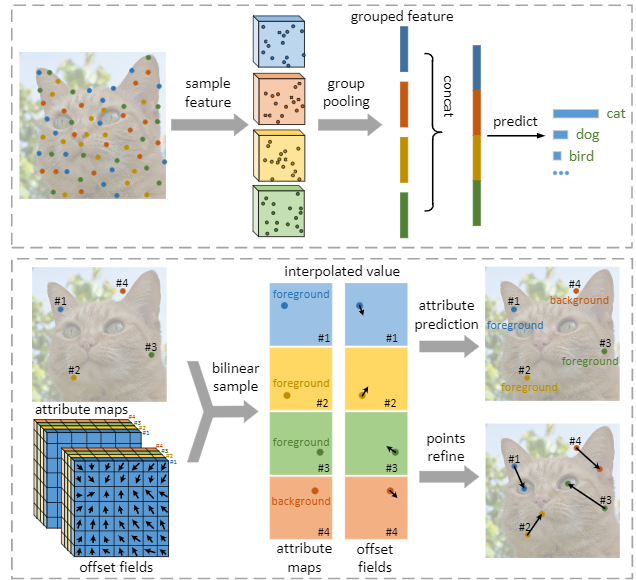

1 Dense RepPoints: Representing Visual Objects with Dense Point Sets

作者:Yang Ze,Xu Yinghao,Xue Han,Zhang Zheng,Urtasun Raquel,Wang Liwei,Lin Stephen,Hu Han

机构:北京大学,香港中文大学

简介:本文提出了一种对象表示法,称为dense Rep Points,用于灵活而详细地建模对象外观和几何体。与边界框的粗几何定位和特征提取不同,DenseRepPoints自适应地将一组密集的点分布到对象上具有重要几何意义的位置,为对象分析提供信息提示。技术的发展是为了解决与监督训练从图像片段和符号密集点集相关的挑战,并使这种广泛的表示在理论上是可行的。此外,该表示的多功能性被用于在多个粒度级别上建模对象结构。稠密的表示点显著提高了面向几何的可视化理解任务的性能,包括在具有挑战性的COCO基准测试中对象检测的1:6AP增益。

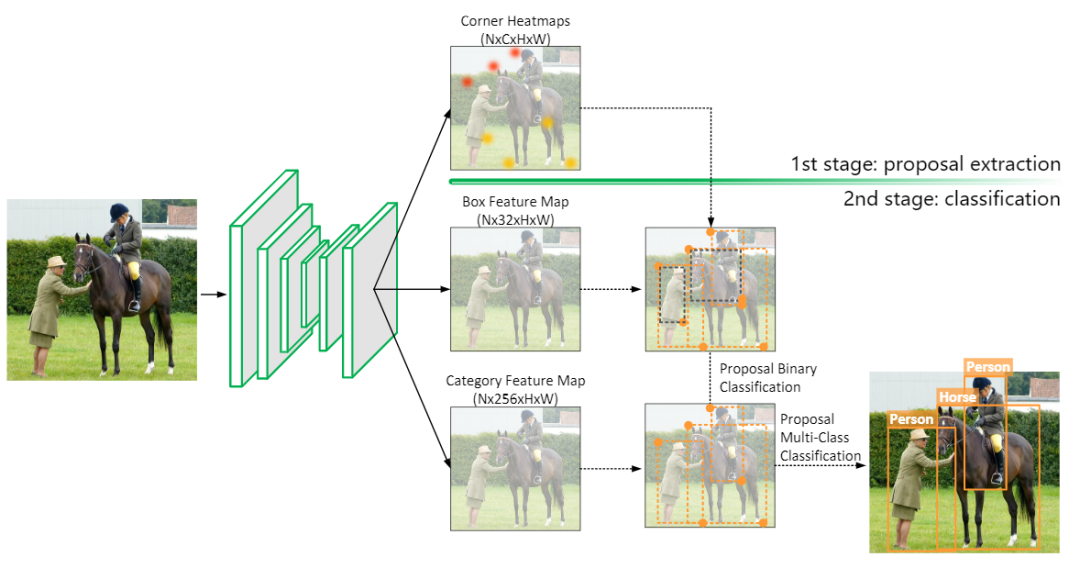

2 Corner Proposal Network for Anchor-free, Two-stage Object Detection

作者:Kaiwen Duan,Lingxi Xie,Honggang Qi,Song Bai,Qingming Huang,Qi Tian

机构:中国科学院大学,华为

简介:目标检测的目标是确定目标在图像中的类别和位置。本文提出了一种新的无锚的两阶段框架,该框架首先通过寻找潜在的角点组合来提取多个目标方案,然后通过独立的分类阶段为每个方案分配一个类别标签。作者证明这两个阶段分别是提高查全率和查准率的有效解决方案,并且可以集成到一个端到端网络中。他们的方法被称为角点建议网络(Corner proposition Network,CPN),它具有检测不同尺度对象的能力,并且避免了被大量的误报建议所迷惑。在MS-COCO数据集上,CPN达到了49.2%的AP,这在现有的目标检测方法中具有竞争力。CPN同样适用于计算效率的场景,在26.2/43.3fps时,CPN的AP达到41.6%/39.7%,超过了大多数具有相同推理速度的竞争对手。

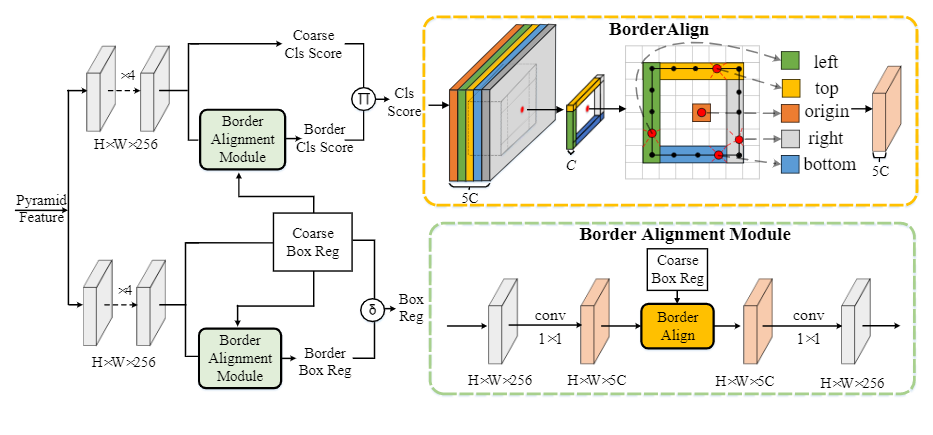

3 BorderDet: Border Feature for Dense Object Detection

作者:Han Qiu,Yuchen Ma,Zeming Li,Songtao Liu,Jian Sun

机构:旷视科技,西安交通大学

简介:密集型目标探测器依赖于滑动窗口模式,它可以在规则的图像网格上预测目标。同时,采用网格点上的特征映射生成边界盒预测。点特征使用方便,但可能缺少精确定位的明确边界信息。本文提出了一种简单高效的边界对齐算子,从边界的极值点提取“边界特征”,以增强点特征。在BorderAlign的基础上,作者设计了一种新的检测体系结构BorderDet,它明确地利用了边界信息来实现更强的分类和更精确的定位。使用ResNet-50主干,他们的方法将单级探测器FCOS提高了2.8 AP增益(38.6 v.s.41.4)。通过ResNeXt-101-DCN主干,他们的BorderDet获得了50.3 AP,优于现有的最新方法。

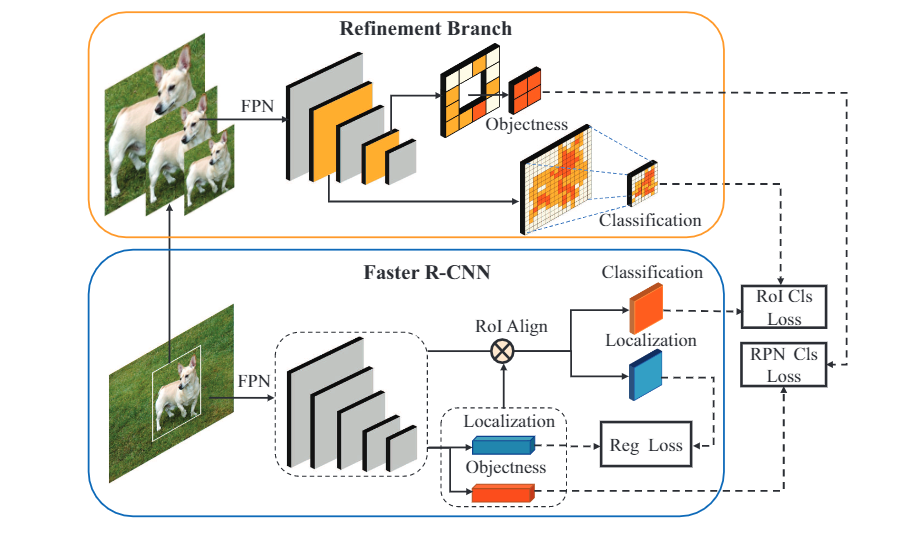

4 Multi-Scale Positive Sample Refinement for Few-Shot Object Detection

作者:Jiaxi Wu,Songtao Liu,Di Huang,Yunhong Wang

机构:北京航空航天大学

简介:少镜头目标检测(FSOD)有助于检测器适应训练实例较少的看不见的类,在手动标注耗时或数据采集受限的情况下非常有用。与以往利用少量镜头分类技术来促进FSOD的尝试不同,本研究强调了处理尺度变化问题的必要性,该问题由于样本分布的独特性而具有挑战性。为此,作者提出了一种多尺度正样本优化(MPSR)方法来丰富FSOD中的目标尺度。它生成多尺度正样本作为目标金字塔,并在不同尺度上对预测进行细化。作者通过将其作为一个辅助分支集成到流行的快速R-CNN和FPN架构中,展示了它的优势,提供了一个强大的FSOD解决方案。在PASCAL-VOC和MS-COCO上进行了多个实验,结果表明,该方法取得了最新的结果,显著优于其他同类方法,显示了其有效性。

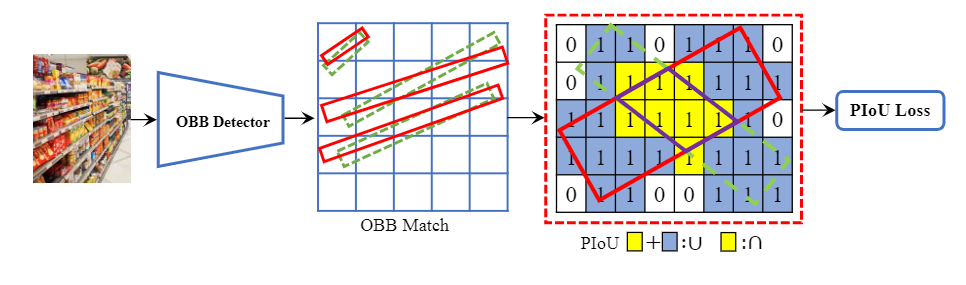

5 PIoU Loss: Towards Accurate Oriented Object Detection in Complex Environments

作者:Zhiming Chen,Kean Chen,Weiyao Lin,John See,Hui Yu,Yan Ke,Cong Yang

机构:扩博智能,上海交通大学

简介:使用定向包围盒(OBB)进行目标检测,可以减少与背景区域的重叠,从而更好地定位旋转对象。现有的OBB方法大多建立在水平包围盒探测器上,通过引入一个额外的角度维度,通过距离损失来优化。然而,由于距离损失只会最小化OBB的角度误差,并且它与IoU松散相关,因此它对高宽高比的对象不敏感。因此,提出了一种新的损失,像素IoU(PIoU)损失,利用角度和IoU进行精确的OBB回归。PIoU损失由IoU度量导出,采用像素形式,简单易行,适用于水平和定向包围盒。为了证明其有效性,作者评估了基于锚定和无锚框架的PIoU损失。实验结果表明,PIoU损耗可以显著提高OBB探测器的性能,特别是对于高宽高比和复杂背景的目标。此外,以前的评估数据集不包括对象具有高宽高比的场景,因此引入了一个新的数据集Retail50K,以鼓励社区采用OBB检测器来适应更复杂的环境。

6 Boosting Weakly Supervised Object Detection with Progressive Knowledge Transfer

7 Probabilistic Anchor Assignment with IoU Prediction for Object Detection

8 HoughNet: Integrating near and long-range evidence for bottom-up object detection

9 OS2D: One-Stage One-Shot Object Detection by Matching Anchor Features

10 End-to-End Object Detection with Transformers

11 Dynamic R-CNN: Towards High Quality Object Detection via Dynamic Training